Muchas veces escuchamos hablar dentro del marketing digital acerca del SEO, pero la historia no es reciente y se remonta a hace algunas décadas. Los algoritmos de búsqueda de los motores de búsqueda han evolucionado constantemente y cada día son más complejos. Aunque hoy en día, las estrategias para realizar SEO o SEM, o indexar un sitio web es más fácil, no siempre la historia ha sido así.

Tim Berners Lee conocido por ser el padre de la Web es un científico de la computación británico que publicó en 1991 el primer servidor Web. Este se encontraba en el CERN (Organización Europea para la Investigación Nuclear) y fue puesto en línea el 6 de agosto de 1991. Esto realizado por él, proporcionó una explicación sobre lo que era el World Wide Web, cómo uno podría tener un navegador y cómo establecer un servidor web. Este fue también el primer directorio Web del mundo, ya que Berners-Lee mantuvo una lista de otros sitios Web aparte del suyo.

En el año de 1993 se liberó para que fuera utilizada por cualquier persona del mundo y adenás era libre de costo. Así que durante 1993 y 1994, muchas personas empezaron a desarrollar las primeras páginas web del mundo y aquí es donde también surge el hecho de tener alguna forma para buscar los sitios web que aparecían diariamente en línea.

Así que, a partir de ese momento algunos programadores se dieron a la tarea de desarrollar alguna forma para poder buscar contenidos en línea, entonces prácticamente con el nacimiento de la Web aparecieron también los primeros buscadores.

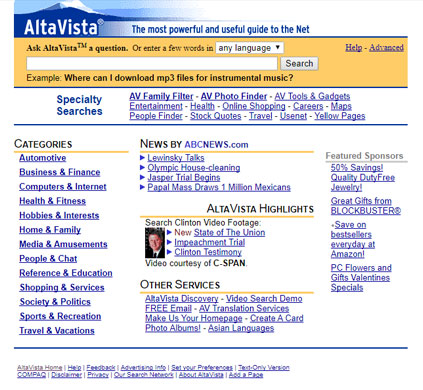

A mediados de la década de los noventa, aparece el primer buscador popular conocido como AltaVista el cuál fue lanzado en los primeros meses de 1995 y, en su momento, llegó a ocupar el primer lugar como índice de búsqueda. AltaVista lograba su búsqueda a través de las etiquetas localizadas en las Meta Keywords.

A mediados de la década de los noventa, aparece el primer buscador popular conocido como AltaVista el cuál fue lanzado en los primeros meses de 1995 y, en su momento, llegó a ocupar el primer lugar como índice de búsqueda. AltaVista lograba su búsqueda a través de las etiquetas localizadas en las Meta Keywords.

Si querías que tu página pudiera ser rastreada por AltaVista se debía ingresar esas palabras clave en una lista dentro del apartado de la meta información, pero el problema es que se empezó a abusar de esta técnica a tal punto que muchos sitios utilizaban palabras claves que tenían un alto impacto en búsquedas aunque dichas palabras no tuvieran nada que ver con el contenido. Por ejemplo, si se tenía un sitio web que fuera de un taller mecánico se utilizaban palabras claves como "Britney Spears" o "Super Bowl" o cualquier palabra que tuvieron un alto porcentaje de búsqueda aunque no existiera una relación entre la Meta Keyword y el contenido que realmente ofrecía el sitio. Esto hizo que las búsquedas en este navegador no tuvieran realmente la relevancia o la calidad de búsqueda que esperaría el usuario en ese tiempo.

Es entonces, cuando en 1998 entra el buscador de Google con una fórmula diferente para encontrar una nueva forma de búsqueda a través del PageRank. El Page Rank es la forma en que Google mide la importancia de una web. Cuando una página enlaza a otra web, esta transmite un valor, y este valor depende del propio Page Rank de la página que enlaza. El índice otorgaba un valor al sitio web, dependiendo de la cantidad y calidad de enlaces que apuntaran al sitio. Pero aquí empezó otro problema que fue la proliferizaron de las granjas de enlaces, es decir, formas no orgánicas o naturales para generar backlinks a los sitios web.

Es entonces, cuando en 1998 entra el buscador de Google con una fórmula diferente para encontrar una nueva forma de búsqueda a través del PageRank. El Page Rank es la forma en que Google mide la importancia de una web. Cuando una página enlaza a otra web, esta transmite un valor, y este valor depende del propio Page Rank de la página que enlaza. El índice otorgaba un valor al sitio web, dependiendo de la cantidad y calidad de enlaces que apuntaran al sitio. Pero aquí empezó otro problema que fue la proliferizaron de las granjas de enlaces, es decir, formas no orgánicas o naturales para generar backlinks a los sitios web.

Estas malas prácticas fueron penalizadas por ser maliciosas y automatizadas a través de robots por las cuales muchas webs cayeron en su posicionamiento.

En los siguientes años, Google se volvió el buscador dominante. En algunos países domina las búsquedas hasta con el 90% de las mismas. Y esta evolución también ha hecho que Google haya tenido que actualizar constantemente su algoritmo de búsqueda

En los primeros años 2000, 2001 y 2002, Google lo estaba realmente haciendo bien ya que mostraba resultados de búsqueda de alta calidad o con contenido relevante si se comparaba con el resto de los buscadores. Para el año 2000, aparece Google AdWords, para el 2002 Google saca su primera API. Sin embargo, a pesar de todas estas cosas que empezaron a aparecer en buscadores, muchos webmasters descubrieron que si su sitio aparecía en lo más alto de los resultados de las búsquedas por la utilización de oraciones o frases populares que pudieran atraer más tráfico hacia el sitio, empezaron a intercambiar links con amigos (otros webmasters) o incluso con sitios que no tenían nada que ver.

En los primeros años 2000, 2001 y 2002, Google lo estaba realmente haciendo bien ya que mostraba resultados de búsqueda de alta calidad o con contenido relevante si se comparaba con el resto de los buscadores. Para el año 2000, aparece Google AdWords, para el 2002 Google saca su primera API. Sin embargo, a pesar de todas estas cosas que empezaron a aparecer en buscadores, muchos webmasters descubrieron que si su sitio aparecía en lo más alto de los resultados de las búsquedas por la utilización de oraciones o frases populares que pudieran atraer más tráfico hacia el sitio, empezaron a intercambiar links con amigos (otros webmasters) o incluso con sitios que no tenían nada que ver.

Se dieron cuenta de que lo que más querían es tener una gran cantidad de links hacia su sitio lo que hacía que se incrementara el ranking del sitio. También se dieron cuenta de que los resultados podían ser fácilmente manipulados y así, muchas marcas empezaron lo que se llamó la manipulación del juego lo que ocasionó que se fueran deteriorando y devaluando la calidad de los contenidos. Es así que en 2003 sale Google el algoritmo conocido como "Florida" que tenía como tarea penalizar a todas las páginas que consideraba spam y que usaban tácticas poco éticas como abusar de las keywords para manipular a los motores de búsqueda.

Así que Matt Cutts, uno de los empleados mejor conocido dentro de la empresa de Google, decidió combatir esta práctica de spam y en el 2005 publicó en su blog acerca de las actualizaciones en el algoritmo que evitarían a toda costa las granjas de links y todos aquellos procesos o sitios web que dieran links de mala o baja calidad.

También penalizó a las Doorway Pages que son páginas web que se crean para indexar spam. Esto es, para mandar spam al índice de un motor de búsqueda insertando resultados para frases particulares con el propósito de enviar a los visitantes a una página diferente. También son conocidas como páginas puente, páginas del portal, saltar páginas, páginas de entrada, Doorway Pages y por otros nombres. Las Doorway Pages lo que hacen es redireccionar a los visitantes sin su conocimiento utilizando alguna forma de camuflaje. Esto usualmente cae en el SEO Black Hat que es el uso de técnicas para engañar a los buscadores con el fin de obtener resultados provechosos para quien lo hace en los resultados de búsqueda SERP.

También penalizó a las Doorway Pages que son páginas web que se crean para indexar spam. Esto es, para mandar spam al índice de un motor de búsqueda insertando resultados para frases particulares con el propósito de enviar a los visitantes a una página diferente. También son conocidas como páginas puente, páginas del portal, saltar páginas, páginas de entrada, Doorway Pages y por otros nombres. Las Doorway Pages lo que hacen es redireccionar a los visitantes sin su conocimiento utilizando alguna forma de camuflaje. Esto usualmente cae en el SEO Black Hat que es el uso de técnicas para engañar a los buscadores con el fin de obtener resultados provechosos para quien lo hace en los resultados de búsqueda SERP.

Este fue uno de los grandes logros que el buscador de Google obtuvo en ese año ya que Google penalizó a grandes marcas por el uso indebido de las páginas puente. En el 2006, por ejemplo, a BMW literalmente lo penalizó sacando a la empresa de su buscador durante un periodo de tiempo por malas prácticas, reforzando así y lanzando una fuerte advertencia hacia todos aquellos que utilizaban metodologías de esta índole.

Es casi imposible mencionar todos los algoritmos que se han dado durante los últimos años, así que haré una breve compilación de algunos y compartiré más adelante algunas ligas por si desean saber más.

Para el 2008, Google Suggest fue creado para añadir calidad en la búsqueda del usuario. Ahora, cuando se busca palabras como por ejemplo la palabra Ciudad de México, te ofrece abajo de la barra de búsqueda, un desplegable en el que indica varias sugerencias y alternativas populares relacionadas con la palabra que se busca, por ejemplo: Ciudad de México tiempo, Ciudad de México lugares de interés. El algoritmo Suggest toma diversos factores entre los cuales se encuentra la frecuencia con la que se ha buscado cada palabra en concreto.

Durante 2009, Google Caffeine mejoró notablemente la velocidad de indexación de las páginas web. Se puede decir que logró que el rastreo de los spiders o arañas para la indexación y clasificación fuera casi tiempo real. Cabe mencionar que en ese mismo año Microsoft descontinúa Live Search e introduce al mercado el buscador de Bing.

En el año 2010, Google cambió completamente la forma en que las búsquedas eran indexadas. Esto se dio porque esencialmente servicios como Twitter ofrecían contenidos o información de manera más rápida, así que los usuarios no ingresaban a Google a buscar contenido reciente porque ese contenido no era publicado tan rápidamente... Twitter era mucho más efectivo para manejar esto. Así que para no quedar rezagado, Google mezcló su algoritmo para intentar publicar los contenidos más recientes de una manera más efectiva, ya que la forma clásica como se manejaba el buscador era a través de la cantidad de ligas y si un artículo era muy antiguo, la probablilidad de que este estuviera mejor posicionado era muy alta aunque no fuera un artículo novedoso o actualizado, Google lo entendía como una página relevante sobre un tópico en particular, aunque esto no fuera totalmente cierto.

Así que Google realizó cambios para que si el contenido era relevante para la audiencia a pesar de tener poco tiempo en línea, lo indexaba ya que era capaz de determinar de mejor forma a través de diferentes cosas, como la autoridad del dominio o recomendaciones como la sugerida en 2012 de tener el sitio responsivo o con contenido optimizado para teléfonos móviles de que se trataba de un tema actualizado o reciente, y esto es porque en gran medida muchas de las consultas o búsquedas se dan desde los dispositivos móviles que han ido desplazando poco a poco a las computadoras de escritorio.

En el sitio de sergioramirez.org, está un artículo interesante con varios de los cambios en los algoritmos realizados por Google a través de los años. Por si les interesa conocer más a detalle los cambios más relevantes.

Cabe mencionar que Google actualiza constantemente su motor de búsqueda y en ocasiones se llega a más de 500 actualizaciones durante el transcurso de un año. Incluso se dice que en 2017 hubo más de 600 cambios durante el año. Algunas actualizaciones son imperceptibles para los usuarios mientras que otras son realmente un cambio drástico en el manejo del SEO.

Los buscadores, así como las diferentes tecnologías que tiene internet en su ecosistema, siempre están en constante cambio. Nada es estático, al menos nada de lo que gira en el mundo del marketing digital y del internet. Una persona profesionista en mercadotecnia debe de estar contínuamente capacitándose para poder aplicar los conocimientos adecuados en el SEO. Lo que hoy funciona, quizás mañana no. Lo que hoy es una buena práctica, mañana puede ser que los buscadores la consideren como una práctica opuesta.

Es interesante ver todo el proceso evolutivo de los buscadores, en particular del buscador de Google porque la cantidad de algoritmos que se generan siempre tendrán como finalidad la mejora de búsqueda para el usuario final.

Cuando se suscriba al blog, le enviaremos un correo electrónico cuando haya nuevas actualizaciones en el sitio para que no se las pierda.